To isté čo pri #20 akurát s väčším rezervoárom + pridané korelácie medzi váhami rezervoárovej matice a transfer entropie tj. ![]()

Parametre siete

| Standart | Normalized | Normalized & OG | Normalized & ON | |

|---|---|---|---|---|

| Veľkosť rezervoiru | 100 | 100 | 100 | 100 |

| Train Length | 1000 | 1000 | 1000 | 1000 |

| Test length | 1000 | 1000 | 1000 | 1000 |

| Runs | 10 | 10 | 10 | 10 |

| W | N(0,1) | N(0,1) | N(0,1) | N(0,1) |

| Win MG | Unif[-0.5,0.5] | Unif[-0.5,0.5] | Unif[-0.5,0.5] | Unif[-0.5,0.5] |

| Win NARMA | Unif[0,0.4] | Unif[0,0.4] | Unif[0,0.4] | Unif[0,0.4] |

| Spectral radius | unscaled | 0.9 | 0.9 | 0.9 |

| Ortogonal | null | null | gradient descent | gradient descent |

| Wout training | pinv | pinv | pinv | pinv |

| Bias | false | false | false | false |

| Leaking rate | 1 | 1 | 1 | 1 |

| OG/ON iterations | 0 | 0 | 30 | 30 |

| OG/ON eta | 0 | 0 | 0.03 | 0.07*0.9**t |

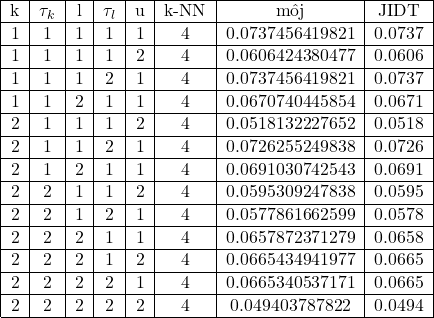

Parametre estimátorov

| k_history | k_tau | l_history | l_tau | u | k | |

|---|---|---|---|---|---|---|

| TE | 1 | 1 | 1 | 1 | 1 | 4 |

| AIS | 1 | 1 | null | null | null | 4 |

Mackey – Glass

Mean reservoir

| Standart | Normalized | Normalized & OG | Normalized & ON | |

|---|---|---|---|---|

| Mackey - Glass | 0.0096 | 0.6245 | 0.6117 | 0.6351 |

| NARMA | 0.0093 | 0.0922 | 0.0801 | 0.0945 |

NRMSE

| Standart | Normalized | Normalized & OG | Normalized & ON | |

|---|---|---|---|---|

| Mackey - Glass | 1.1149 | 0.9577 | 0.6748 | 1.0472 |

| NARMA | 2.4119 | 0.8664 | 0.8338 | 0.8433 |

InputOutput TE

| Standart | Normalized | Normalized & OG | Normalized & ON | |

|---|---|---|---|---|

| Mackey - Glass | -0.004 | -0.0210 | -0.0212 | -0.0256 |

| NARMA | -0.0013 | 0.3732 | 0.3743 | 0.3714 |

Mean reservoir-output TE

| Standart | Normalized | Normalized & OG | Normalized & ON | |

|---|---|---|---|---|

| Mackey - Glass | -0.0001 | 0.3516 | 0.3601 | 0.3532 |

| NARMA | -0.0006 | 0.0015 | 0.0014 | 0.0018 |

NARMA

AIS

Mean reservoir AIS

| Standart | Normalized | Normalized & OG | Normalized & ON | |

|---|---|---|---|---|

| Mackey - Glass | 0.0036 | 2.1694 | 2.1763 | 2.1910 |

| NARMA | 0.0023 | 0.1618 | 0.1675 | 0.1730 |